ソフトバンクがTransformerを核にした新AIアーキテクチャーを開発し、GPU上でOTA実証を実施しました。平均約338µsの超低遅延処理を達成し、上りスループットはベースライン比で約30%改善。CNN比でも約8%向上し、AI‑RANの実用化が一歩前進しました。

Transformerで変わる5Gリアルタイム処理

ソフトバンクは、AIを活用してRANを高度化する「AI for RAN」の研究開発において、無線信号処理に高性能AIモデル「Transformer」を適用した新しいAIアーキテクチャーを開発しました。本アーキテクチャーはGPU上で動作させ、3GPPの5G標準仕様に準拠した実環境(OTA)でのリアルタイム動作確認を行っています。この実証により、AIを用いない従来方式と比べて通信品質を大幅に改善できることを示しました。

実証結果では、アップリンクのチャネル補間にTransformerを適用したことで、ベースライン方式と比べ上りスループットが約30%向上しました。さらに従来のCNN活用時と比較しても約8%の上昇を確認しており、AIモデルの高性能化が実環境でのスループット改善に直結することが裏付けられています。処理速度面でも、5Gの要求する1ms未満の実時間処理を満たし、平均約338µsという超低遅延を達成。これはCNN利用時より約26%高速化した数値であり、高性能化と低遅延化の両立に成功しています。

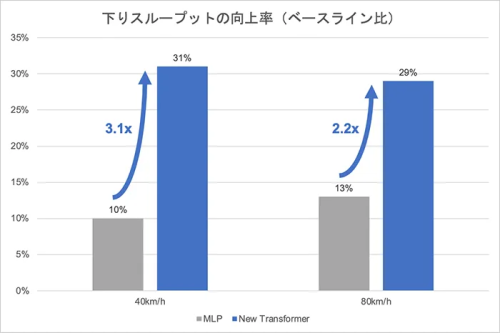

シミュレーションでは、基地局が端末へ最適ビームを割り当てるためのSRS予測においても大きな効果が出ました。従来MLPによる評価で時速80kmの端末で下り約13%改善だったのに対し、本アーキテクチャーでは時速80kmで約29%、時速40kmで約31%の下りスループット向上を確認し、改善率が2倍以上になる結果を得ています。本アーキテクチャーは自己注意機構により無線信号の広範な相関を把握し、信号振幅などの物理情報を正規化せず保持する独自設計で高精度を実現します。加えて、チャネル補間・推定、SRS予測、復調など多様なタスクに対応できる汎用性を持ち、GPUを基盤にすることで将来のAIモデル進化もソフトウエア更新で取り込める点が運用面の優位性を生みます。ソフトバンクはこれら技術の実用化を加速し、5G‑や6G時代に向けたネットワーク高度化を目指すとしています。

詳しくは「ソフトバンク」の公式ページまで。

レポート/DXマガジン編集部 權